Das die sogenannten "Social Signals" das SEO Thema 2011 überhaupt waren, brauchen wir an dieser Stelle wohl keinen mehr erzählen. Interessant ist aber die Frage: Welche Social Signals wirken sich am stärksten auf das Ranking einer Webseite aus? Wir haben hier mal die wohl wichtigsten Social Signals zusammengefasst:

Montag, 26. Dezember 2011

Mittwoch, 7. Dezember 2011

SEO Blogs vs. natürliche Blogs

Jeder SEO kennt sie, manche betreiben sie und ein Experte erkennt sie sofort. Die SEO Blogs. Mit SEO Blog meinen wir an dieser Stelle natürlich keine Blogs wie dieser hier, wo es überwiegend um SEO Themen geht. Nein, es geht um Blogs zu einem bestimmten Thema, die redaktionell durchaus auf den ersten Blick hochwertigen Content liefern, primär aber aus Linkbuildingzwecken erstellt und gefüttert werden.

Freitag, 2. Dezember 2011

Richtig Verlinken aus SEO Sicht - die verweisende Seite

Auch die Relevanz der verweisenden Seite in Bezug auf den Anchor Text ist wichtig.

Hier hilft es der Zielseite wenn bei der verweisenden Seite folgendes erfüllt ist:

Hier hilft es der Zielseite wenn bei der verweisenden Seite folgendes erfüllt ist:

- keyword im title / description der Seite

- keyword in der Überschrift (<h1>, <h2> oder <h3>)

- keyword in der URL der Seite

- keyword in <Alt> tags und Dateinamen von Bildern

- keyword <strong>

Richtig Verlinken aus SEO Sicht - Bildlinks

Auch Verlinkungen von extern von Bildern heraus oder bei der internen Verlinkung über Bilder sollte man den Bilddateinamen und den "alt Tag" richtig gestalten.

Hier schaut es dann so aus:

Hier schaut es dann so aus:

<img src="www.domain.de/folder/keyword.jpg"

width="100" height="100"

alt="Keyword" />

Hier noch ein paar allgemeine Tipps zum Thema "alt Tags"

Suchmaschinen werten den “alt Tag” aus, so dass es sinnvoll ist, bei jeder Grafik ein solches Attribut zu verwenden und darin die wichtigen Keywords unterzubringen. Des weiteren wird der “alt Tag” auch zur Indexierung bei Bildersuchmaschinen (z.B. Google Bildersuche) verwendet. Achte darauf, dass Sie beim “alt Tag” nur wenige Suchgebriffe vorkommen und benutze auch nur solche Begriffe, die auf der Seite auch in Textform vorkommen. Bei jeder Grafik sollten unterschiedliche "alt Tags" verwendet werden, zu vermeiden sind zu häufige Wiederholungen des gleichen Keywords.

Hier noch ein paar allgemeine Tipps zum Thema "alt Tags"

Suchmaschinen werten den “alt Tag” aus, so dass es sinnvoll ist, bei jeder Grafik ein solches Attribut zu verwenden und darin die wichtigen Keywords unterzubringen. Des weiteren wird der “alt Tag” auch zur Indexierung bei Bildersuchmaschinen (z.B. Google Bildersuche) verwendet. Achte darauf, dass Sie beim “alt Tag” nur wenige Suchgebriffe vorkommen und benutze auch nur solche Begriffe, die auf der Seite auch in Textform vorkommen. Bei jeder Grafik sollten unterschiedliche "alt Tags" verwendet werden, zu vermeiden sind zu häufige Wiederholungen des gleichen Keywords.

Richtig Verlinken aus SEO Sicht - externe Textlinks

Nun schauen wir uns mal an wie man richtig von extern verlinkt.

Nehmen wir mal an, deine Website hat die Adresse www.seite-fuer-den-hund.de

So wäre ein guter Code (Wenn man die Seite auf das Keyword "Hund" optimiert):

<a href="http://www.seitefuerdenhund.de">Hund</a>

Mit title (kann man sich streiten, ob das Sinn macht) schaut der Code beispielsweise so aus:

<a href="http://www.seitefuerdenhund.de" title="Die Hundeseite">Hund</a>

Soll der Link in neuem Fenster geöffnet werden, schaut der Code so aus:

<a href="http://www.seitefuerdenhund.de" target="_blank">Hund</a>

Nehmen wir mal an, deine Website hat die Adresse www.seite-fuer-den-hund.de

So wäre ein guter Code (Wenn man die Seite auf das Keyword "Hund" optimiert):

<a href="http://www.seitefuerdenhund.de">Hund</a>

Mit title (kann man sich streiten, ob das Sinn macht) schaut der Code beispielsweise so aus:

<a href="http://www.seitefuerdenhund.de" title="Die Hundeseite">Hund</a>

Soll der Link in neuem Fenster geöffnet werden, schaut der Code so aus:

<a href="http://www.seitefuerdenhund.de" target="_blank">Hund</a>

Richtig Verlinken aus SEO Sicht - interne Verlinkung

Kommen wir zuerst mal zum Thema interen Verlinkung. Ich weiss nicht wie viele Webmaster das immer noch falsch machen, kann aber gut sein, dass es > 50 % sind. Hier mal der grösste Fehler bei vielen Webseiten (Stichwort duplicate content).

Der Link auf die Startseite sollte auf die "leere" Domain und nicht auf die Indexseite zeigen!

Der Link auf die Startseite sollte auf die "leere" Domain und nicht auf die Indexseite zeigen!

Richtig: <a href="/"> oder <a href="./">

Falsch: <a href="index.html">

Donnerstag, 24. November 2011

Sind Social Bookmark Buttons Linkbaits?

|

| bunte Parasiten: Social Bookmarks |

Viele Webseiten haben verschiedenste kleine bunte Knöpfe am Ende ihrer Seiten oder unter ihrem Beitrag. Beispiele sind Facebook, Google Buzz, Twitter, StumbleUpon, Digg, MySpace, Delicious, Multiply, Mister Wong, Baidu, Blogger, Bebo, Amazon, LinkedIn, Hellotxt, Bitly, Google Translate, Google Reader, myAOL, Netvibes, Instapaper, Hacker News, etc.

Doch bringen sie irgend etwas? Dem Betreiber wohl eher weniger, weil diese Buttons extrem selten geklickt werden und wenn jemand dann mal ein social Bookmark der Seite macht, dann ist es z.B. bei Mister Wrong ein nofollow.

Ganz anders schaut dagegen der Nutzen für die Webseiten die hinter den Buttons stehen aus. Die bekommen durch die Links immer schön Linkpower ab. Wenn man die bunten Parasiten dann auf jeder Unterseite hat, kommt schon einiges zusammen.

Montag, 14. November 2011

Linkbuilding mit Social Media

Social Signals sind ja mittlerweile ein entscheidendes Rankingkriterium. Aber nicht nur Erwähnungen in Tweeds oder Facebook Likes bringen Vorteile im Bereich der Offpageoptimierung. Eine kurze Einführung wie man zusätzlich Linkbuilding mit Social Media betreiben kann, gibt es auf einem Video von SEOmoz.

Diesmal erklärt Mike King wie die allgemeine Vorgehensweise hier ist. Zugegeben, das ist für deutsche SEOs fast noch etwas Zukunftsmusik, weil gerade in Nischenbranchen noch nicht so viele deutsche soziale Profile bei den einschlägigen Dienstleistern vorliegen. Aber interessant ist es auf jeden Fall.

http://www.seomoz.org/blog/scalable-link-building-using-social-media-whiteboard-friday

Diesmal erklärt Mike King wie die allgemeine Vorgehensweise hier ist. Zugegeben, das ist für deutsche SEOs fast noch etwas Zukunftsmusik, weil gerade in Nischenbranchen noch nicht so viele deutsche soziale Profile bei den einschlägigen Dienstleistern vorliegen. Aber interessant ist es auf jeden Fall.

http://www.seomoz.org/blog/scalable-link-building-using-social-media-whiteboard-friday

Montag, 7. November 2011

Bilder in Google Adwords - Produkterweiterungen

Immer öfter sieht man nun bei Google Adwords nun Bilder in Verbindung mit den klassischen Textanzeigen. Aber woher kommen eigentlich die Bilder ?

Seit einiger Zeit ist es möglich im Merchant Center hinterlegte Produkte in die AdWords Anzeigen einzubinden. Das Anzeigen der Bilder erfolgt üblicherweise durch Klicken der Plusbox. Es sind allerdings neu auch schon Ansichten aufgetaucht wo direkt ein Bild ausgeliefert wurde, ohne dass man vorher auf die Plusbox klicken musste. Ob das neuer Standart wird oder noch in der Erprobungsphase ist, ist derzeit noch unklar.

Wenn die Einblendung von Bildern nun auch ohne die Plusbox kommt, wird dieses eine extrem interessante Werbeform, vor allem für Onlineshops.

Bearbeitet wird das ganze im Adwords Manager unter "Anzeigenerweiterungen" und dort unter "Produkterweiterungen". Hier kann auch eine Verknüpfung zum Merchant Center erfolgen. Die angezeigten Produkte lassen sich hierbei noch über einen Produktfilter genauer spezifizieren.

Seit einiger Zeit ist es möglich im Merchant Center hinterlegte Produkte in die AdWords Anzeigen einzubinden. Das Anzeigen der Bilder erfolgt üblicherweise durch Klicken der Plusbox. Es sind allerdings neu auch schon Ansichten aufgetaucht wo direkt ein Bild ausgeliefert wurde, ohne dass man vorher auf die Plusbox klicken musste. Ob das neuer Standart wird oder noch in der Erprobungsphase ist, ist derzeit noch unklar.

Wenn die Einblendung von Bildern nun auch ohne die Plusbox kommt, wird dieses eine extrem interessante Werbeform, vor allem für Onlineshops.

Bearbeitet wird das ganze im Adwords Manager unter "Anzeigenerweiterungen" und dort unter "Produkterweiterungen". Hier kann auch eine Verknüpfung zum Merchant Center erfolgen. Die angezeigten Produkte lassen sich hierbei noch über einen Produktfilter genauer spezifizieren.

Montag, 31. Oktober 2011

Neue Werbeformate Facebook Page Post Ads

|

| Facebook Page Post Ads |

Ein Grund also, dass wir uns hier auch mit Neuigkeiten bei Facebook beschäftigen, auch wenn sie keinen direkten Einfluss auf das Ranking von Webseiten haben.

Mit Page Post Ads und Premium Page Post Ads stellt Facebook ein neues Werbemittel vor. Durchaus eine wichtige Sache und vergleichbar damit, wie wenn Google die Möglichkeiten der beliebten Adwords Textanzeigen deutlich erweitern würde.

Dienstag, 25. Oktober 2011

SEO, Google Ranking und der Serverstandort

Ranking Faktoren gibt es ja eine Menge. Um die 200 sollen es mindestens sein. Einer davon ist der Serverstandort, Hier gibt es auch eindeutige Aussagen von Matt Cuts, die Einfluss auf die strategische Planung zum Serverstandort bei Unternehmen im deutschsprachigen Umfeld mit Internationaler Ausrichtung und deutschsprachige Unternehmen im Allgemeinen haben sollten.

Hat man sich historisch anders aufgegellt gibt es allerdings noch einen Workarround: Virtuelles lokales Hosting. Hierbei bleibt der Server wo er ist, aber jeder Seite, die dezidiert einem Nutzer in einem anderen Land zugeschrieben wird, bekommt eine virtuelle IP Adresse.

- Der Serverstandort sollte idealerweise mit dem Land übereinstimmen, in dem bei Suchmaschinenabfragen am besten gerankt werden soll.

- Für Unternehmen mit nur nationaler Ausrichtung oder überwiegend nationaler Ausrichtung sollte der Serverstandort im eigenen Land sein.

Hat man sich historisch anders aufgegellt gibt es allerdings noch einen Workarround: Virtuelles lokales Hosting. Hierbei bleibt der Server wo er ist, aber jeder Seite, die dezidiert einem Nutzer in einem anderen Land zugeschrieben wird, bekommt eine virtuelle IP Adresse.

Freitag, 21. Oktober 2011

Neues kostenloses Backlink Check Tool

Nachdem der Yahoo Siteexplorer keine Backlinks mehr liefert schaut es mit kostenlosen Tools die nicht auf SEOmoz Datenbasis zurückgreifen eher mau aus. Für professionelle SEOs sicher kein Problem, weil sie längst auf kostenpflichtige Tools mit eigener Datenbasis umgestiegen sind. Für alle SEOs die die Kosten für ein solches Backlinkcheck-Tool scheuen hat sich die Datenbasis, um z.B. die Backlinks von Mitbewerbern zu tracken deutlich verschlechtert.

Nun gibt es aber ein neues Tool mit eigener Datenbasis, mit dem man Backlinks im deutschsprachigem Web checken kann. Erste Tests haben ergeben, dass es schon erstaunlich gut funktioniert.

Welches Geschäftsmodell dahinter steht und ob sich das Tool, nachdem es in der breiten Masse bekannt ist in einen kostenpflichtigen Dienst umwandelt, ist nicht bekannt.

Zum backlinktest.com

Nun gibt es aber ein neues Tool mit eigener Datenbasis, mit dem man Backlinks im deutschsprachigem Web checken kann. Erste Tests haben ergeben, dass es schon erstaunlich gut funktioniert.

Welches Geschäftsmodell dahinter steht und ob sich das Tool, nachdem es in der breiten Masse bekannt ist in einen kostenpflichtigen Dienst umwandelt, ist nicht bekannt.

Zum backlinktest.com

Mittwoch, 19. Oktober 2011

Textlänge Metatags title und description

Absolute SEO Basics sind unique Meta Tags und die richtige Länge der Meta Tags description und title. Umso schlimmer, dass gefühlt mehr als die Hälfte aller Webseiten die im Netz online sind sich nichtmal an diese wirklich einfachen Vorgaben halten.

Die Länge wird vor allem limitert durch die Darstellung im Google Sniplet. Ausserdem gibt es dann vor allem im Title Tag noch eine absolute und relative Gewichtung der Keywords von Google. Man kann davon ausgehen das alles was beim Title Tag über das 10 Wort hinausgeht von Google nicht mehr stark, wenn überhaupt gewichtet wird. Je weiter ein Keyword vorne steht desto stärker wird es relativ gewichtet, je weniger Keywords verwendet werden, desto stärker werden die einzelnen Keywords absolut gewichtet.

Hier aber vor allem nochmal die empfohlenen maximalen Längen der Metatags:

title: Im Google Sniplet werden maximal 65 Zeichen angezeigt

description: Google zeigt 160 Zeichen maximal bei den Suchergebnissen an.

Die Länge wird vor allem limitert durch die Darstellung im Google Sniplet. Ausserdem gibt es dann vor allem im Title Tag noch eine absolute und relative Gewichtung der Keywords von Google. Man kann davon ausgehen das alles was beim Title Tag über das 10 Wort hinausgeht von Google nicht mehr stark, wenn überhaupt gewichtet wird. Je weiter ein Keyword vorne steht desto stärker wird es relativ gewichtet, je weniger Keywords verwendet werden, desto stärker werden die einzelnen Keywords absolut gewichtet.

Hier aber vor allem nochmal die empfohlenen maximalen Längen der Metatags:

title: Im Google Sniplet werden maximal 65 Zeichen angezeigt

description: Google zeigt 160 Zeichen maximal bei den Suchergebnissen an.

Dienstag, 18. Oktober 2011

Sinn und Unsinn des Google Pagespeed Tools

Unabhängig von einer Registrierung bei den Google Webmaster Tools kann man ja nun unter:

https://developers.google.com/pagespeed/

Das Google Page Speed Tool nutzen, das wirklich in erstaunlicher Geschwindigkeit die Seite analysiert und dazu noch die vorgeschlagenen Maßnahmen nach Prioritäten bewertet.

Bei den getesteten Seiten fast immer als "High priority" dabei ist die Maßnahme "Komprimierung aktivieren". Hier wird dann zumeist vorgeschlagen die .js und .css Dateien zu komprimieren. Was natürlich sinnlos und gefährlich ist. Sollte man es machen wird die Webseite nicht mehr funktionieren.

Aber wir sind sicher, dass Google diesen Schwachpunkt bald behebt.

https://developers.google.com/pagespeed/

Das Google Page Speed Tool nutzen, das wirklich in erstaunlicher Geschwindigkeit die Seite analysiert und dazu noch die vorgeschlagenen Maßnahmen nach Prioritäten bewertet.

Bei den getesteten Seiten fast immer als "High priority" dabei ist die Maßnahme "Komprimierung aktivieren". Hier wird dann zumeist vorgeschlagen die .js und .css Dateien zu komprimieren. Was natürlich sinnlos und gefährlich ist. Sollte man es machen wird die Webseite nicht mehr funktionieren.

Aber wir sind sicher, dass Google diesen Schwachpunkt bald behebt.

Donnerstag, 13. Oktober 2011

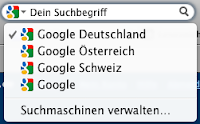

Firefox Google Suche auf Deutsch

|

| Firefox Google Suche "customised" |

Eine prima Abhilfe schaffen hier die Plugins, wo man die Google Suche rechts oben beliebig konfigurieren kann.

http://mycroft.mozdev.org/google-search-plugins.html

Hier kann man auch gleich verschiedene Suchsprachen und Länder hinterlegen. Sehr praktisch wenn man als SEO auch an anderen deutschsprachigen Rankings wie der

- Firefox Google Suche Schweiz auf Deutsch

- Firefox Google Suche Österreich auf Deutsch

interessiert ist.

Mittwoch, 12. Oktober 2011

Sichtbarkeitsindex SEO Visibility von Searchmetrics

Eine weitere Möglichkeit eines free Services um Webseiten anhand eines Indizies zu vergleichen ist die SEO Visibility von Searchmetrix, analog zu dem Sistrix Sichtbarkeitsindex zeidgt die SEO Visibility die Sichtbarkeit der eingegebenen Domain in der organischen Suche. Zur Ermittlung der SEO Visibility durchsucht Searchmetrics den Google-Index nach Millionen von Keywords.

Auch hier kann man analog wie beim Sistrix Sichtbarkeitsindex eine gewisse Grundfunktion ohne Account benutzen und bekommt zur Zeit im Gegensatz zu Sistrix einen gewissen zeitlichen verlauf der SEO Visibility ausgeliefert.

Zur Abfrage der Searchmetrix SEO Visibility

Auch hier kann man analog wie beim Sistrix Sichtbarkeitsindex eine gewisse Grundfunktion ohne Account benutzen und bekommt zur Zeit im Gegensatz zu Sistrix einen gewissen zeitlichen verlauf der SEO Visibility ausgeliefert.

Zur Abfrage der Searchmetrix SEO Visibility

Online Ping Service Tool

|

| Pingler Free Ping Service |

Freitag, 23. September 2011

Matt Cutts klärt auf: URLs - Unterstriche oder Bindestriche ?

Nun gibt es von allerhöchster Stelle eine Aussage wie Google Unterstriche und Bindestriche in URLs interpretiert.

Unterstriche werden als verbindende Zeichen und nicht als Trennzeichen bewertet. Es werden also nicht die Wörter getrennt indexiert, sondern als ein Wort. "Wort1_Wort2" wird also als "Wort1Wort2" indexiert.

Bindestriche werden als Trennzeichen bewertet. "Wort1-Wort2" in einer URL wird also als "Wort1" und "Wort2" indexiert.

Aber: laut Matt Cutts macht das in In der Praxis macht das keinen großen Unterschied. Es ist beim Ranking eher ein sekundärer Faktor. Falls man bereits eine Website habt, die Unterstriche verwendet und sie bereits so funktioniert wie man das möchte, wird nicht empfohlen jede einzelne URL umzuschreiben.

Unterstriche werden als verbindende Zeichen und nicht als Trennzeichen bewertet. Es werden also nicht die Wörter getrennt indexiert, sondern als ein Wort. "Wort1_Wort2" wird also als "Wort1Wort2" indexiert.

Bindestriche werden als Trennzeichen bewertet. "Wort1-Wort2" in einer URL wird also als "Wort1" und "Wort2" indexiert.

Aber: laut Matt Cutts macht das in In der Praxis macht das keinen großen Unterschied. Es ist beim Ranking eher ein sekundärer Faktor. Falls man bereits eine Website habt, die Unterstriche verwendet und sie bereits so funktioniert wie man das möchte, wird nicht empfohlen jede einzelne URL umzuschreiben.

Mittwoch, 14. September 2011

Social Media Statistiken von Webseiten

In einem etwas älterem Post haben wir die neuen Funktionen de Open Site Explorers dargestellt. Auch er bietet in der Pro Version die Social Media Statistiken von Webseiten. Wer aber keine Pro Version hat und trotzdem an die Statistiken will, kann ein anderes Tool nutzen.

Sharedcount bietet die Social Sharing Statistik jeder beliebigen Seite - egal ob Facebook, Google+, Twitter oder Linkedin

http://sharedcount.com/

Sharedcount bietet die Social Sharing Statistik jeder beliebigen Seite - egal ob Facebook, Google+, Twitter oder Linkedin

http://sharedcount.com/

Labels:

Offpageoptimierung,

SEO Tools,

Social Media

Montag, 22. August 2011

Ping Services vs. "Abruf wie durch Googlebot"

In den Webmaster Tools gibt es nun die neue Funktion "Abruf wie durch Googlebot", hier kann man geänderte URLs einreichen und es können maximal 50 einzelne URLs pro Woche und 10 URLs inklusive aller verknüpften Seiten pro Monat eingereicht werden. Laut Google wird die Webseite dann sofort neu gecrawlt.

Auch für "Nicht-Webmaster" gibt es ein Formular

https://www.google.com/webmasters/tools/submit-url

wo man selbiges für jede beliebige URL (sinnvollerweise erst nach Captchaeingabe) machen kann.

Damit haben die manuell zu bedienenden Pingservices wohl weniger Existenzberechtigung, das automatische pingen auf neue Unterseiten (z.B. in Form eines Wordpress Plugins) ist aber nach wie vor sinnvoll um neue Seiten schnell indexiert zu bekommen.

Auch für "Nicht-Webmaster" gibt es ein Formular

https://www.google.com/webmasters/tools/submit-url

wo man selbiges für jede beliebige URL (sinnvollerweise erst nach Captchaeingabe) machen kann.

Damit haben die manuell zu bedienenden Pingservices wohl weniger Existenzberechtigung, das automatische pingen auf neue Unterseiten (z.B. in Form eines Wordpress Plugins) ist aber nach wie vor sinnvoll um neue Seiten schnell indexiert zu bekommen.

Montag, 15. August 2011

Google Panda in Deutschland - na und ?

|

| Google Panda nun auch in Deutschland |

Netterweise haben sich eine Kollegen die Mühe gemacht und mal herausgestellt, wer denn so die Gewinner und die Verlierer sind, wie z.B. im Searchmetrics Blog.

Hier gibt es keinerlei Überraschungen, nur Comments von unserer Seite:

Das Gutefrage.net zu den Hauptverlierern gehört, begrüssen wir. Es war immer unter unserem Niveau diese Plattform als (dofollow) Linkquelle für Linkbuilding zu verwenden. Hätte der Betreiber hier von Anfang an ein nofollow auf die Links der User gesetzt, wäre die Plattform sympathischer dahergekommen.

Ein bisschen enttäuscht sind wir davon, das ebay in einigen Bereichen recht ungeschoren davongekommen ist. Nach wie vor belegt ebay mit Subdomains / Unterverzeichnissen zu wichtigen Keywords Top Positionen, obwohl die Inhalte der Kategorien fast nur aus Sofortkaufeinträgen von kommerziellen Händlern bestehen, die genauso in anderen, spezialisierten Webshops zu finden sind, ohne dass sich beim Kauf ebay und sein Bezahldienst paypal (zu) viel von dem Verkaufserlös abzieht.

Freitag, 29. Juli 2011

Open Site Explorer mit neuen Funktionen

|

| SEOmoz Open Site Explorer |

So kann man sich mit dem Reiter "Top Pages" die Qualität der externen Verlinkung auf Deeplinks anzeigen lassen. Auf dem Reiter "Linking Domains" kann man sich anzeigen lassen von welchen Seiten einer Root Domain die eigenen Seiten verlinkt werden. Neben der Anchor Text Verteilung hat uns besonders die "Compare Link Metrics" Funktion gefallen. Hier kann man Seiten anhand der wichtigsten SEOmoz Kennzahlen vergleichen. Auch anhand dem in der SEOmoz Sitebar ohne PRO Funktion nicht dargestelltem MozThrust

Neu auch für PRO User: Erstmals werden die Social Media Metrics in Form von Facebook Likes/Shares, Tweeds und Google +1 Werten ausgegeben.

Thumbs up für den Open Site Exporer

Mittwoch, 27. Juli 2011

Facebook Like Button bei blogspot Blog einbauen

Auch den Facebook Like / Gefällt mir Button kann man einfach bei blogspot Blogs einbauen.

Hier die kleine Anleitung:

1. Schritt

Backup von der html Vorlage machen

2. Schritt

Im Backend auf Design -> html bearbeiten gehen und Checkbox "Widget-Vorlagen komplett anzeigen" klicken.

3. Schritt

nach dem <div class='post-footer'> tag folgenen Code einfügen:

<iframe allowTransparency='true' expr:src='"http://www.facebook.com/plugins/like.php?href=" + data:post.url + "&layout=button_count&show_faces=false&width=180&action=like&font=arial&colorscheme=light"' frameborder='0' scrolling='no' style='border:none; overflow:hidden; width:180px; height:30px;'/>

Hier die kleine Anleitung:

1. Schritt

Backup von der html Vorlage machen

2. Schritt

Im Backend auf Design -> html bearbeiten gehen und Checkbox "Widget-Vorlagen komplett anzeigen" klicken.

3. Schritt

nach dem <div class='post-footer'> tag folgenen Code einfügen:

<iframe allowTransparency='true' expr:src='"http://www.facebook.com/plugins/like.php?href=" + data:post.url + "&layout=button_count&show_faces=false&width=180&action=like&font=arial&colorscheme=light"' frameborder='0' scrolling='no' style='border:none; overflow:hidden; width:180px; height:30px;'/>

Google +1 Button bei blogspot Blog einfügen

Neu in diesem Blog ist der Google +1 Button.

Hier die kleine Anleitung, wie man ihn bei einem blogspot Blog einbaut:

1. Schritt

Backup von der html Vorlage machen

2. Schritt

Im Backend auf Design -> html bearbeiten gehen und Checkbox "Widget-Vorlagen komplett anzeigen" klicken.

3. Schritt

vor dem abschliessenden </head> tag folgenen Code einfügen:

<script type="text/javascript" src="http://apis.google.com/js/plusone.js"> {lang: 'de'} </script>

4. Schritt

nach dem <div class='post-footer'> tag folgenen Code einfügen:

<div style='float:left'>

<g:plusone size="medium" expr:href="data:post.url"/>

</div>

Hier die kleine Anleitung, wie man ihn bei einem blogspot Blog einbaut:

1. Schritt

Backup von der html Vorlage machen

2. Schritt

Im Backend auf Design -> html bearbeiten gehen und Checkbox "Widget-Vorlagen komplett anzeigen" klicken.

3. Schritt

vor dem abschliessenden </head> tag folgenen Code einfügen:

<script type="text/javascript" src="http://apis.google.com/js/plusone.js"> {lang: 'de'} </script>

4. Schritt

nach dem <div class='post-footer'> tag folgenen Code einfügen:

<div style='float:left'>

<g:plusone size="medium" expr:href="data:post.url"/>

</div>

Dienstag, 19. Juli 2011

Google +1 Schaltfläche als Button einfügen

Also ob wir nicht schon genug Social Media Buttons auf den Webseiten hätten…

Trotzdem ist es wohl für eine Seite die sich "Social Media optimiert" nennt ein must have den Google +1 Button einzubinden.

Glücklicherweise geht das sehr einfach.

<script type="text/javascript" src="https://apis.google.com/js/plusone.js">

{lang: 'de'}

</script>

vor den abschliessenden </body> tag einfügen

und ein

<g:plusone size="medium"></g:plusone>

für den Button in den Source Code.

Einzige Parameter sind also die Language und die Size.

Trotzdem ist es wohl für eine Seite die sich "Social Media optimiert" nennt ein must have den Google +1 Button einzubinden.

Glücklicherweise geht das sehr einfach.

<script type="text/javascript" src="https://apis.google.com/js/plusone.js">

{lang: 'de'}

</script>

vor den abschliessenden </body> tag einfügen

und ein

<g:plusone size="medium"></g:plusone>

für den Button in den Source Code.

Einzige Parameter sind also die Language und die Size.

Labels:

Offpageoptimierung,

Social Media,

Social Network

Freitag, 15. Juli 2011

6 Wahrheiten über den Pagerank

Zitiert aus dem Google Webmaster Zentrale Blog,

Susan Moskwa, Webmaster Trends Analyst , 15.07.11

"… weisen wir die Webmaster seit Jahren immer wieder darauf hin, dass sie sich nicht so sehr auf den PageRank als Messwert für den Erfolg ihrer Website fixieren sollen…."

"… aber nur weil ein Wert leicht nachzuverfolgen ist, ist er noch lange kein genauer Indikator dafür, was auf eurer Website vor sich geht…"

"… der öffentlich angezeigte PageRank unterscheidet sich also von dem Wert, den unser Algorithmus tatsächlich für das Ranking verwendet ..."

"… warum also sich mit einer Zahl beschäftigen, die bestenfalls drei Zwischenschritte von eurem wirklichen Ziel entfernt ist ..."

… der PageRank ist viel zu langsam, um euch verlässlich Aufschluss darüber zu geben, aufgrund welcher Änderungen er gestiegen oder gefallen ist ...

"… für manche Website-Inhaber ist der PageRank ihrer Website wichtig, da sie nur bei einem hohen PageRank Käufer für Links von ihrer Website finden. Das Kaufen oder Verkaufen von Links mit dem Ziel, den PageRank zu beeinflussen, verstößt gegen unsere Webmaster-Richtlinien und hat sehr wahrscheinlich negative Folgen für eure Website …"

Susan Moskwa, Webmaster Trends Analyst , 15.07.11

"… weisen wir die Webmaster seit Jahren immer wieder darauf hin, dass sie sich nicht so sehr auf den PageRank als Messwert für den Erfolg ihrer Website fixieren sollen…."

"… aber nur weil ein Wert leicht nachzuverfolgen ist, ist er noch lange kein genauer Indikator dafür, was auf eurer Website vor sich geht…"

"… der öffentlich angezeigte PageRank unterscheidet sich also von dem Wert, den unser Algorithmus tatsächlich für das Ranking verwendet ..."

"… warum also sich mit einer Zahl beschäftigen, die bestenfalls drei Zwischenschritte von eurem wirklichen Ziel entfernt ist ..."

… der PageRank ist viel zu langsam, um euch verlässlich Aufschluss darüber zu geben, aufgrund welcher Änderungen er gestiegen oder gefallen ist ...

"… für manche Website-Inhaber ist der PageRank ihrer Website wichtig, da sie nur bei einem hohen PageRank Käufer für Links von ihrer Website finden. Das Kaufen oder Verkaufen von Links mit dem Ziel, den PageRank zu beeinflussen, verstößt gegen unsere Webmaster-Richtlinien und hat sehr wahrscheinlich negative Folgen für eure Website …"

Dienstag, 12. Juli 2011

Sistrix Sichtbarkeitsindex ohne Account abfragen

Es gibt einige SEO Tools, die versuchen die Sichtbarkeit einer Domain bei Google Hilfe eines Indexwertes visuell darstellen können. Wichtig ist jedoch, dass man die Bewertung der Sichtbarkeit nicht nur auf den Indexwert reduziert. Es kann auch vorkommen, dass eine Domain gut ranked, jedoch allein diese Rankings keine hohe Sichtbarkeit ausmacht. Gerade bei Webseiten mit sehr spitzer Zielgruppe und / oder regionaler Zielgruppe ist der Sichtbarkeitsindex mit Vorsicht zu geniessen.

Gut geeignet ist so ein Index jedoch um die eigene Domain mit der Sichtbarkeit der Mitbewerber zu vergleichen.

Das bekannteste Tool ist hier das Sistrix Tool, dieses ist allerdings Kostenpflichtig. Trotzdem gibt es eine Möglichkeit den Sichtbarkeitsindex (allerdings ohne zeitlichen Verlauf) ohne Login abzurufen und zwar hier:

https://tools.sistrix.de/sichtbarkeitsindex/

Gut geeignet ist so ein Index jedoch um die eigene Domain mit der Sichtbarkeit der Mitbewerber zu vergleichen.

Das bekannteste Tool ist hier das Sistrix Tool, dieses ist allerdings Kostenpflichtig. Trotzdem gibt es eine Möglichkeit den Sichtbarkeitsindex (allerdings ohne zeitlichen Verlauf) ohne Login abzurufen und zwar hier:

https://tools.sistrix.de/sichtbarkeitsindex/

Dienstag, 28. Juni 2011

Pagerank update

Totgesagte leben länger - heisst ein altes deutsches Sprichwort. Nachdem sich Google mit dem vorletztem update des Pageranks fast 300 Tage Zeit gelassen hat, dauerte es diesmal nur 158 Tage.

Mit einigen überraschenden Erkenntnissen.

Mit einigen überraschenden Erkenntnissen.

- Neue Freeblogs, die mit der gleichen Sorgfalt gepflegt wurden, mit fast identischen Links gefüttert wurden und fast identische Erstellungszeiträume hatten, wurden zwischen "keine Pagerank Informationen verfügbar" und PR 3 bewertet.

- Seiten die auf einmal keinen Pagerank oder "keine Pagekank Informationen vefügbar" haben, sind in der SERP trotzdem noch gut und erreichen Top 10 Platzierungen

Labels:

Allgemeine News,

News bei Google,

Offpageoptimierung

Mittwoch, 22. Juni 2011

Suchmaschinen Ranking Faktoren 2011

Es gibt neues bei SEOmoz !

Rand Fishkin, umfassend präsenter CEO von SEOmoz hat die 2011 Trends und Entwicklungen bei den Rankingfaktoren vorgestellt.

Und, wen wunderts, gleich mal herausgestellt was an Bedeutung gewonnen hat.

Am meisten Bedeutung hat gewonnen hat:

- Der Nutzen der Seite für die User

- "Social Signals" der Seite

- CTR und Bounce Rate der Seite

Am meisten verloren hat

- exactly keyword match domain name (also Keyworddomains)

zu diesem Thema gab es ja schon einen Post hier.

Aber natürlich Pflichtaufgabe für jeden SEO sich das mal ganz genau anzuschauen:

Zum Artikel

Montag, 20. Juni 2011

SEO, Social Media und Facebook im Speziellen

SEO und Social Media wachsen zusammen - eine unbestrittenen Tatsache. Aber was sind die Fakten?

Da ist zum einen unser allseits präsenter Rand Fishkin, der letzten Monat eine Analyse vorgestellt hat die die Korrelation zwischen Facebook Shares, Likes und Comments aufgezeigt hat.

Zum anderen haben wir da unsern mindestens genauso präsenten Matt Cuts, der letztens auf der SMX in einer Podiumsdiskussion auf die Frage zu den Korrelationsdaten von SEOmoz sagte, Facebook lässt Google nicht an ihre Daten, also warum sollten die Shares, Likes, Comments oder andere Facebook Daten als Rankingfaktor genutzt werden.

Was ist nun die Wahrheit. Wahr ist, dass Google an viele Daten von Facebook kommt, ohne mit ihnen eine Deal haben zu müssen. Klar ist: Social Media Daten wie Shares, Likes, Comments sind ein Rankingfaktor bei Google.

Trotzdem sollte man sich nicht verrückt machen lassen. Die Betonung liegt auf "EIN" Rankingfaktor bei Google.

Übrigens SEO Wissen gibt es noch nicht auf Facebook. Aber ihr könnt die Posts hier auf Twitter abbonieren. Dazu einfach auf den kleinen netten Vogel unten klicken:

Da ist zum einen unser allseits präsenter Rand Fishkin, der letzten Monat eine Analyse vorgestellt hat die die Korrelation zwischen Facebook Shares, Likes und Comments aufgezeigt hat.

Zum anderen haben wir da unsern mindestens genauso präsenten Matt Cuts, der letztens auf der SMX in einer Podiumsdiskussion auf die Frage zu den Korrelationsdaten von SEOmoz sagte, Facebook lässt Google nicht an ihre Daten, also warum sollten die Shares, Likes, Comments oder andere Facebook Daten als Rankingfaktor genutzt werden.

Was ist nun die Wahrheit. Wahr ist, dass Google an viele Daten von Facebook kommt, ohne mit ihnen eine Deal haben zu müssen. Klar ist: Social Media Daten wie Shares, Likes, Comments sind ein Rankingfaktor bei Google.

Trotzdem sollte man sich nicht verrückt machen lassen. Die Betonung liegt auf "EIN" Rankingfaktor bei Google.

Übrigens SEO Wissen gibt es noch nicht auf Facebook. Aber ihr könnt die Posts hier auf Twitter abbonieren. Dazu einfach auf den kleinen netten Vogel unten klicken:

Labels:

Facebook,

Offpageoptimierung,

Social Media,

Social Network

Montag, 6. Juni 2011

Rich Sniplets und SEO

Die eigentliche Idee bei den Rich Sniplets ist etwas in den Hintergrund gerückt und so wird der Begriff Rich Sniplets unter SEO Leuten gar nicht so oft gebraucht. Bei Rich Sniplets gibt es aber einige Unterschiede:

Es gibt Rich Sniplets man selber über den Code steuert. Diese sind kein SEO Thema, da sie keinen direkten Einfluss aufs Ranking haben.

Es gibt Rich Sniplets die Google selber generiert. Hier gibt es zum Beispiel die Sitelinks die Google meist bei den Platz 1 Ergebnissen unter dem eigentlichen Sniplet anzeigt. Diese haben keinen direkten Einfluß auf das Ranking, sind aber sicher in Hinblick auf die CTR sehr gut und somit indirekt ein Einflußfaktor fürs Ranking. Diese Sitelinks kann man bedingt über die Google Webmastertools steuern

Dann gibt es noch die Rich Sniplets die Google selber aus den Google Places Einträgen und den Bewertungsportalen bastelt. Diese sind bei Suchen mit lokalem Bezug SEO technisch sehr wichtig. Hierauf hat man keinen direkten Einfluss. Man kann es nur so steuern, dass Google es dann (hoffentlich) so darstellt wie man das haben will.

Es gibt Rich Sniplets man selber über den Code steuert. Diese sind kein SEO Thema, da sie keinen direkten Einfluss aufs Ranking haben.

Es gibt Rich Sniplets die Google selber generiert. Hier gibt es zum Beispiel die Sitelinks die Google meist bei den Platz 1 Ergebnissen unter dem eigentlichen Sniplet anzeigt. Diese haben keinen direkten Einfluß auf das Ranking, sind aber sicher in Hinblick auf die CTR sehr gut und somit indirekt ein Einflußfaktor fürs Ranking. Diese Sitelinks kann man bedingt über die Google Webmastertools steuern

Dann gibt es noch die Rich Sniplets die Google selber aus den Google Places Einträgen und den Bewertungsportalen bastelt. Diese sind bei Suchen mit lokalem Bezug SEO technisch sehr wichtig. Hierauf hat man keinen direkten Einfluss. Man kann es nur so steuern, dass Google es dann (hoffentlich) so darstellt wie man das haben will.

Mittwoch, 25. Mai 2011

301 Weiterleitung von root in ein Unterverzeichnis

Ein gängiges Szenario für SEOs: Man hat eine neue Domain registriert und um diese zu entwickeln setzt man statt einer Platzhalterseite mit Bild, Text und Impressum gleich einen Blog auf und schreibt schonmal ein paar themenrelevante Beiträge. Aber irgendwann ist der finale Content fertig, der Blog aber optimalerweise auch mit den deeplinks schon ganz gut verlinkt. Also ab mit dem Blog in ein /blog/ Verzeichnis. Nun muss noch die richtige .htaccess 301 Weiterleitung auf den Server geschubst werden, damit nichts verlorengeht. Diese sollte dann so ausschauen:

RewriteEngine On #mod_rewrite aktivieren

#alle Anfragen auf Blogartikel im Root auf /blog/ umleiten!

RewriteCond %{REQUEST_FILENAME} !-f

RewriteCond %{REQUEST_FILENAME} !-d

RewriteRule ^(.*)$ http://www.your-site.de/blog/$1 [R=301,L]

Eine umfangreiche Anleitung wie man einen kompletten Umzug mit dem beliebten Wordpress Blog macht findet ihr hier.

RewriteEngine On #mod_rewrite aktivieren

#alle Anfragen auf Blogartikel im Root auf /blog/ umleiten!

RewriteCond %{REQUEST_FILENAME} !-f

RewriteCond %{REQUEST_FILENAME} !-d

RewriteRule ^(.*)$ http://www.your-site.de/blog/$1 [R=301,L]

Eine umfangreiche Anleitung wie man einen kompletten Umzug mit dem beliebten Wordpress Blog macht findet ihr hier.

Montag, 23. Mai 2011

Erfahrungen mit dem Panda Algorithmus update

Ich denke über den Google Panda Algorithmus update wurde nun schon genug geschrieben. Stellt sich die Frage ob er schon in Deutschland angekommen ist und wenn nein, dann wann er ankommt.

Mir ist vor 3 Tagen eine plötzliche, unerklärbare Herabstufung einer von mir betriebenen Webseite aufgefallen. Nach genauer Analyse bemwerkte ich einen Rechtschreibfehler im desripton tag. Durchaus denkbar, dass Google den als negativfaktor indentifizeirt hat und sich das im Ranking bemerkbar gemacht hat. Der Fehler ist mittlerweile korrigiert und wir sind gespannt, ob sich die Webseite "erholt". Wie werden berichten.

Wir freuen uns auf jeden Fall über das Panda Update auch im deutschsprachigen Raum. Wer qualitativ hochwertige Inhalte hat wird belohnt, wer spammt oder irgendwelche Webseiten mit automatisch erstellten Inhalt bertreibt wird bestraft. So muss es sein und deshalb: Thumbs up!

Mir ist vor 3 Tagen eine plötzliche, unerklärbare Herabstufung einer von mir betriebenen Webseite aufgefallen. Nach genauer Analyse bemwerkte ich einen Rechtschreibfehler im desripton tag. Durchaus denkbar, dass Google den als negativfaktor indentifizeirt hat und sich das im Ranking bemerkbar gemacht hat. Der Fehler ist mittlerweile korrigiert und wir sind gespannt, ob sich die Webseite "erholt". Wie werden berichten.

Wir freuen uns auf jeden Fall über das Panda Update auch im deutschsprachigen Raum. Wer qualitativ hochwertige Inhalte hat wird belohnt, wer spammt oder irgendwelche Webseiten mit automatisch erstellten Inhalt bertreibt wird bestraft. So muss es sein und deshalb: Thumbs up!

Mittwoch, 11. Mai 2011

Page Speed Optimierungstool von Google

Die Ladezeit einer Webseite hat unter Umständen eine deutlichen Einfluss auf die Ranking Performance. Gerade bei unoptimierten Bildern oder grossen, nachladenden JavaScript Bibiotheken können teilweise Ladezeiten erreicht werden, die sich negativ auf die Ranking Performance auswirken können.

Hier gibt es einige Tools, mit denen man die Seite nach unnötigen ladezeitverlängerten Elementen untersuchen kann. Auch Google stellt ein Tool zur Verfügung. Dieses empfiehlt sich in jedem Fall man über die zu optimierende Seite laufen zu lassen:

http://pagespeed.googlelabs.com/

Hier gibt es einige Tools, mit denen man die Seite nach unnötigen ladezeitverlängerten Elementen untersuchen kann. Auch Google stellt ein Tool zur Verfügung. Dieses empfiehlt sich in jedem Fall man über die zu optimierende Seite laufen zu lassen:

http://pagespeed.googlelabs.com/

Dienstag, 26. April 2011

Probleme beim RSS Feed anmelden aus Freeblogs

Freeblogs erfreuen sich ja starker Beliebtheit. Doch Vorsicht. Wer sich einen schönen Freeblog erstellt und dann den Traffic / Linkpower durch Einträge in RSS Verzeichnisse stärken will, kann auf Probleme stossen. Manche Freebloganbieter verhindern das Auslesen der Feeds durch RSS Verzeichnisse. Also sollte man das erstmal überprüfen, bevor man den Blog aufsetzt.

Ein Tool hierfür ist:

www.chegu.de/AWT/HTTP-Header.html

Hiermit kann man den http header des Feeds auslesen.

Steht da dann irgendwas drin mit:

Connection: close, z.B in Zusammenhang mit Content-Length: 100

dann kann es hier Probleme geben und das Auslesen der RSS Feeds wird verhindert.

Ein Tool hierfür ist:

www.chegu.de/AWT/HTTP-Header.html

Hiermit kann man den http header des Feeds auslesen.

Steht da dann irgendwas drin mit:

dann kann es hier Probleme geben und das Auslesen der RSS Feeds wird verhindert.

Donnerstag, 21. April 2011

Lieblingstools: Seitenrepot.de

Ein sehr gutes Tool um einen schnellen Überblick über eine Webseite zu bekommen ist seitenreport.de. Hier werden die wichtigsten Onpage und Offpagekriterien abgeklopft und übersichtlich mit Erklärung dargestellt. Zudem ist das Tool in einer einfachen Version kostenlos. Man hat zwar nur 3 Abfragen pro Tag frei, aber wem das nicht reicht, der kann entsprechend Zahlungspflichtig upgraden.

www.seitenreport.de

www.seitenreport.de

Donnerstag, 14. April 2011

SEO und Social Networks für Anfänger

|

| Der "gefällt mir" Button von Facebook |

Also schauen wir uns mal an, wie das in der einfachsten Form geht.

1. Einen "gefällt mir" Button für die Webseite erstellen. Den Code hierfür generiert Facebook auf Wunsch selber. Dazu kann man dieses Tool benutzen:

http://developers.facebook.com/docs/reference/plugins/like/

2. Das Code Sniplet auf der eigenen Webseite einbinden

3. Optional den geposteten Text und das veröffentlichte Foto auf Facebook festlegen:

<meta property="og:title" content="The title of your page" />

<meta property="og:site_name" content="The name of your web site" />

<meta property="og:image" content="The URL of the best picture for this page" />

4. Wenn man die oben definierten, zu übergebenden Inhalte überprüfen oder nach einer Änderung den Facebook Cache für diese Inhalte zu löschen will, dann macht man das hier:

http://developers.facebook.com/tools/lint

Viel Spass und eine Menge Reichweite in den Social Networks !

Samstag, 9. April 2011

Keyword Domains verlieren an Relevanz

Zitat von Daniela Loesser, Google Search Quality Team:

"Einige Leute haben sich beschwert, dass wir zu viel Wert auf Keywords in Domains legen. Daher haben wir uns überlegt, dass wir die Mischung etwas anpassen und sozusagen den Regler im Algorithmus herunterdrehen, sodass es bei zwei verschiedenen Domains nicht mehr unbedingt so sehr von Vorteil ist, eine Domain mit einem Haufen Keywords darin zu haben."

Diesen Effekt haben wir tatsächlich an einigen unserer Domains gemerkt und bei sehr keywordrelevanten Domains an Ranking verloren. Trotzdem wir der Einfluss der Onpageoptimierung der gleiche bleiben, was für die SEOs bedeutet, dass nun der Content der Seite stärker zählt. Allerdings wird man wohl Rankingvorteile gegenüber Mitbewerbern ohne Keyworddomain verlieren.

"Einige Leute haben sich beschwert, dass wir zu viel Wert auf Keywords in Domains legen. Daher haben wir uns überlegt, dass wir die Mischung etwas anpassen und sozusagen den Regler im Algorithmus herunterdrehen, sodass es bei zwei verschiedenen Domains nicht mehr unbedingt so sehr von Vorteil ist, eine Domain mit einem Haufen Keywords darin zu haben."

Diesen Effekt haben wir tatsächlich an einigen unserer Domains gemerkt und bei sehr keywordrelevanten Domains an Ranking verloren. Trotzdem wir der Einfluss der Onpageoptimierung der gleiche bleiben, was für die SEOs bedeutet, dass nun der Content der Seite stärker zählt. Allerdings wird man wohl Rankingvorteile gegenüber Mitbewerbern ohne Keyworddomain verlieren.

Dienstag, 5. April 2011

Google und der +1 Button

Google führt mit dem +1 Button erstmalig ein soziales Empfehlungssystem ein. Dieses ist aber zumindest erstmal nicht für alle Suchenden sichtbar, sondern nur für alle mit denen man über seinen Google Account als Kontakt gelistet ist. Der Service ist also erstmal nur für alle registrierten Google Nutzer.

Nun aber die spannenden Fragen in Bezug auf SEO: Werden die Empfehlungen der User Einfluss auf die organischen Rankings der Webseiten haben ? Das ist auf jeden Fall anzunehmen, da ja auch schon Einträge in anderen Bewertungsportalen massiven Einfluss auf die Rankings haben.

Hier liegt aber auch das Problem. Während man in vielen relevanten Bewertungsportalen zumindest einen halbwegs sinnvollen Kommentar hinterlassen muss, kann man theoretisch ein mehrere hundert Mal am Tag auf +1 Buttons klicken ohne dass (wie im Falle des Ilke Buttons von Facebook) das eigene Profil zugespammt wird.

Theoretisch könnte sich also ein neues Betätigungsfeld für Webworker ergeben, die dann den ganzen Tag nichts anderes machen als verschiedene +1 Buttons zu drücken. Das wird aber erst passieren, wenn deutlich erkennbar ist, dass hier relevante Rankingveränderungen erreichbar sind und wenn Google keine sehr guten Maßnahmen ergreift um hier die Spammer unschädlich zu machen.

Hier der Video zum Google +1 Button:

Nun aber die spannenden Fragen in Bezug auf SEO: Werden die Empfehlungen der User Einfluss auf die organischen Rankings der Webseiten haben ? Das ist auf jeden Fall anzunehmen, da ja auch schon Einträge in anderen Bewertungsportalen massiven Einfluss auf die Rankings haben.

Hier liegt aber auch das Problem. Während man in vielen relevanten Bewertungsportalen zumindest einen halbwegs sinnvollen Kommentar hinterlassen muss, kann man theoretisch ein mehrere hundert Mal am Tag auf +1 Buttons klicken ohne dass (wie im Falle des Ilke Buttons von Facebook) das eigene Profil zugespammt wird.

Theoretisch könnte sich also ein neues Betätigungsfeld für Webworker ergeben, die dann den ganzen Tag nichts anderes machen als verschiedene +1 Buttons zu drücken. Das wird aber erst passieren, wenn deutlich erkennbar ist, dass hier relevante Rankingveränderungen erreichbar sind und wenn Google keine sehr guten Maßnahmen ergreift um hier die Spammer unschädlich zu machen.

Hier der Video zum Google +1 Button:

Dienstag, 29. März 2011

Vergangenheit einer Domain tracken

Wenn man eine neue Domain registrieren will, oder eine breits registrierte Domain kaufen will, kann man normalerweise nichts dazu sagen, ob und wie die Domain früher benutzt wurde.

Im schlechtesten Fall kann eine Domain einen hohen Pagerank haben, dementsprechend teuer sein, aber für Google mit anderen negativen Attributen behaftet sein. Einen hohen Pagerank zu bekommen ist unter Umständen ganz einfach. Man muss nur ein paar Spam Links in Foren und Blogs mit hohem PR setzen und mit ein bisschen Glück kommt man bei einem PR update dann möglichst viel von dem grünen Balken ausgefüllt. Dann kann man die Domain unter Umständen teuer verkaufen, auch wenn die Domain in der Vergangenheit mit wilden Affiliate oder gar Schweinkram Inhalten belegt war.

Im besten Fall registriert man eine neue Domain, die vorher schon über Jahre mit sauberen, themenrelevanten Inhalt belegt war und die der Vorbesitzter hat auslaufen lassen. Nun kann man die Domain Age unter umständen erben.

Damit man bei dem Neukauf / Neuregistierung einer Domain keine Überraschung erlebt kann man die Internet Archive Wayback Machine benutzen. Hier kann man die Vergangenheit einer Domain checken und bekommt mit etwas Glück die Fingerabdrücke der Domain aus der Vergangenheit. Das ist teilweise sehr spannend.

http://waybackmachine.org/

Sonntag, 20. März 2011

Den Wert einer Webseite bestimmen

Wer mal einen netten Spass auf seinem Bildschirm braucht, hier ein deutschsprachiges Tool mit dem man den Wert einer Webseite bestimmen kann:

www.bizzinformation.de

Hier schätzt ein Dienst den Wert einer Webseite und überzeugt durch eine recht professionelle Darstellung. Immerhin ist zu halbwegs wichtigen Webseiten immer ein Vorschaubild vorhanden.

Das interessanteste Aber: Es wird ein sehr detailierter Wert der Webseite angegeben. Doch wie wird der berechnet? Darüber wird keine Auskunft gegeben. Schätzungsweise werden dazu Daten von Alexa herangezogen. Nach ein paar Tests von eigenen Seiten und Seiten von Mitbewerbern aus der selben Branche kommen relativ gesehen einigermassen plausible Ergebnisse heraus. Also: Wer mal 5 Minuten Zeit hat, mal reinschauen lohnt auf jeden Fall.

Montag, 14. März 2011

Wie wichtig ist der Pagerank ?

Für die Beurteilung der Bedeutung einer Seite ist für Google nicht nur der Pagerank von Bedeutung. Sehr wichtig sind auch seitenspezifische Faktoren, wie beispielsweise der Titel, der Inhalt und die URL einer Seite aber auch der Ankertext der Verweise auf diese Seite. Auch Offpagefaktoren wie Authority, Trust und Domainage sind wichtige Faktoren. Es ist ohne weiteres möglich eine sehr gut Onpage optimierte Seite unter die ersten 10 Suchergebnisse zu bringen auch wenn der PR noch bei 0 oder 1 liegt. Der Pagerank ist eine Größe die zuletzt in immer grösseren Abständen aktualisiert wird (zuletzt 300 Tage). Daher ist sie kein zuverlässiger Indikator mehr für die Offpagestärke einer Seite. Wenn man bei der Optimierung einer Seite nur auf die Pageranks der Backlinks schaut, wird man eine kosteneffiziente Optimierung der Seite kaum hinbekommen, da der Pagerank als "Marketinggrösse" viel zu überbewertet ist. Links von Seiten mit einem hohen Pagerank sind zu teuer und oft unnatürlich durch Linkkauf zu bekommen. Dagegen ist der Effekt, den sie im Vergleich zu einem anderen, thematisch hochwertig verlinktem Backlinkmix bringen oft geringer.

Das Ranking von Google wird sich in Hinblick auf die Offpage Optimierung nach wie vor stark auf die Bewertung von Links aufbauen und das wird sich wahrscheinlich in den nächsten Jahren auch nicht ändern. Allerdings wurde der historische Pagerank in den letzten Jahren stark weiterentwickelt und hat keinen wirklichen Bezug mehr zu dem Pagerank, den Google über die Google Toolbar ausgibt. Wir werden uns darauf einstellen müssen, dass das der Trustrank, das Nutzerverhalten oder der Social Graph deutlich an Bedeutung gewinnt. Leider wird uns Google hierbei keinen Wert zwischen 0 und 10 zur Bewertung liefern.

Das Ranking von Google wird sich in Hinblick auf die Offpage Optimierung nach wie vor stark auf die Bewertung von Links aufbauen und das wird sich wahrscheinlich in den nächsten Jahren auch nicht ändern. Allerdings wurde der historische Pagerank in den letzten Jahren stark weiterentwickelt und hat keinen wirklichen Bezug mehr zu dem Pagerank, den Google über die Google Toolbar ausgibt. Wir werden uns darauf einstellen müssen, dass das der Trustrank, das Nutzerverhalten oder der Social Graph deutlich an Bedeutung gewinnt. Leider wird uns Google hierbei keinen Wert zwischen 0 und 10 zur Bewertung liefern.

Donnerstag, 10. März 2011

osCommerce und SEO Module

osCommerce ist unbestritten eines der bekanntesten und am meisten verbreiteten Open-Source-Shopsysteme. Doch wie schaut es hier mit der SEO Tauglichkeit aus? Wir hatten die Aufgabe ein Shopssystem (Version 2.2) SEO tauglich zu machen. In der installierten osCommerce Version waren keinerlei SEO geeignete Funktionen installiert. Keine SEF URLs, keine unique Title und decription Tags möglich.

Also mussten neue SEO Module installiert werden, sogenannte Contributions. Wir haben uns für die beiden Module:

HeaderTags SEO V 3.2.5

Ultimate SEO URLSv22d11

entschieden.

Schnell mal installiert und dann loslegen ? Fehlanzeige. Die Installation beider Module gestaltet sich ziemlich aufwendig und sollte nur von erfahrenen Programmieren durchgeführt werden. Insgesamt 3 Stunden benötigten wir für die Installation und anschliessend noch eine halbe Stunde Bugfixing.

Dafür bekommt man keine wirklich selber frei wählbaren URLs, sondern nur URLs die aus den Produktbeschreibungen generiert werden, aber immerhin frei wählbare title und description Tags. Die Bedienung des Moduls im Backend hierzu ist alles andere als intuitiv, so liesen sich nicht ohne weiteres die ganzen nach der Installation erstmal unbelegten title und description tags automatisch mit Produktüberschriften und Teilen der Produktbeschreibung belegen.

Alles im allen recht ärgerlich, dass ein so weit verbreitetes Shopsystem wie osCommerce eine so mässige und schwierig zu installierende SEO Unterstützung bietet.

Also mussten neue SEO Module installiert werden, sogenannte Contributions. Wir haben uns für die beiden Module:

HeaderTags SEO V 3.2.5

Ultimate SEO URLSv22d11

entschieden.

Schnell mal installiert und dann loslegen ? Fehlanzeige. Die Installation beider Module gestaltet sich ziemlich aufwendig und sollte nur von erfahrenen Programmieren durchgeführt werden. Insgesamt 3 Stunden benötigten wir für die Installation und anschliessend noch eine halbe Stunde Bugfixing.

Dafür bekommt man keine wirklich selber frei wählbaren URLs, sondern nur URLs die aus den Produktbeschreibungen generiert werden, aber immerhin frei wählbare title und description Tags. Die Bedienung des Moduls im Backend hierzu ist alles andere als intuitiv, so liesen sich nicht ohne weiteres die ganzen nach der Installation erstmal unbelegten title und description tags automatisch mit Produktüberschriften und Teilen der Produktbeschreibung belegen.

Alles im allen recht ärgerlich, dass ein so weit verbreitetes Shopsystem wie osCommerce eine so mässige und schwierig zu installierende SEO Unterstützung bietet.

Dienstag, 1. März 2011

Google nimmt die Content Farmen ins Visier

Content Farmen sind Serverfarmen mit Seiten mit kopierten und qualitativ minderwertig Inhalten. Diese wollen Google eine hohe Themenrelevanz vorgaukeln und erzeugen sich durch Verlinkung untereinander eine starke Linkpower. Damit kann man sich viel Traffic generieren, der dann wieder durch Google Anzeigen monetisiert werden kann. Auch kann damit Linkpower an zahlende Kunden weitergegeben werden. Content Farmen sind ein Dorn im Auge von allen SEOs die versuchen nach Google Richtlinien zu optimieren. Nun gibt es einen Algorithmus-Update der zur Zeit nur in den USA läuft, aber nun auch auf andere Länder ausgedehnt werden soll. Ziel ist es diese Seiten aus den Suchergebnissen zu verbannen oder zu blocken.

Montag, 28. Februar 2011

SEO und die Bilder

Keine Angst. Hier kommt jetzt kein Beitrag über die richtige Benennung von Bilddateinamen, <alt> und <title tags>. Für sowas gibt es sicher eine Menge Einsteigertutorials zum Thema Suchmaschinenoptimierung.

Hier beschäftigen wir uns mit dem Thema, welche erweiterten Faktoren bei Bildern das Ranking beeinflussen.

Der erste Punkt ist ganz einfach: Ein grösseres mit den entsprechenden Keywords bestücktes Bild ist relevanter als ein kleines. Logisch. Genau so ist es mit dem Text ja auch.

Schwieriger wird es bei der Motiverkennung. Google versucht auf jeden Fall Motive zu erkennen und die auch thematisch zuzuordnen. Aber anzunehmen, dass man mit der Motivauswahl das Ranking nun relevant beeinflussen kann, wäre sehr verwegen.

Mit der optischen Zeichenerkennung in Bildern (OCR) ist Google sicher soweit, dass es auf Bildern enthaltenen Text speichert. Ist es nun sinnvoll die Bilder mit Text zu belegen? Ich sage nein. Der Googlealgorithmus versucht ja herauszufinden, welche Seiten besonders relevant für den Benutzer bei bestimmten Suchanfragen sind. Und der Benutzer will sicher keine Webseiten haben mit Bildern, die mit Text gespickt sind.

Ein Faktor der sicher auch eine Rolle spielt ist die Ladezeit der Bilder. Gerade in Zeiten der High Speed Breitbandanbindungen werden viele Webmaster hier schlampig und laden die Bilder nicht in der eingebauten Grösse auf die Seite oder speichern sie nicht in der optimalsten Dateigrösse ab. Das hat natürlich Einfluss auf die Ladezeit der Seite. Die ist mit Sicherheit ein Ranking Faktor.

Hier beschäftigen wir uns mit dem Thema, welche erweiterten Faktoren bei Bildern das Ranking beeinflussen.

Der erste Punkt ist ganz einfach: Ein grösseres mit den entsprechenden Keywords bestücktes Bild ist relevanter als ein kleines. Logisch. Genau so ist es mit dem Text ja auch.

Schwieriger wird es bei der Motiverkennung. Google versucht auf jeden Fall Motive zu erkennen und die auch thematisch zuzuordnen. Aber anzunehmen, dass man mit der Motivauswahl das Ranking nun relevant beeinflussen kann, wäre sehr verwegen.

Mit der optischen Zeichenerkennung in Bildern (OCR) ist Google sicher soweit, dass es auf Bildern enthaltenen Text speichert. Ist es nun sinnvoll die Bilder mit Text zu belegen? Ich sage nein. Der Googlealgorithmus versucht ja herauszufinden, welche Seiten besonders relevant für den Benutzer bei bestimmten Suchanfragen sind. Und der Benutzer will sicher keine Webseiten haben mit Bildern, die mit Text gespickt sind.

Ein Faktor der sicher auch eine Rolle spielt ist die Ladezeit der Bilder. Gerade in Zeiten der High Speed Breitbandanbindungen werden viele Webmaster hier schlampig und laden die Bilder nicht in der eingebauten Grösse auf die Seite oder speichern sie nicht in der optimalsten Dateigrösse ab. Das hat natürlich Einfluss auf die Ladezeit der Seite. Die ist mit Sicherheit ein Ranking Faktor.

Samstag, 26. Februar 2011

.htaccess 301 redirect index.html auf root Verzeichnis

Wer immer vor dem Problem steht, dass Google statt einem Verzeichniss oder der Root in den Suchergebnissen die /index.html listet und nicht die Root oder das Verzeichnis, könnte versucht sein, dieses Problem durch einen einfachen Eintrag in die .htaccess zu lösen. Ich habe das leichtsinnig und ohne Recherche so gemacht:

Redirect permanent /d/index.html http://www.meinedomain.com/d/

Das Ganze hat dann einen Loop erzeugt der zu Folge hatte, dass die Seite nicht mehr erreichbar war.

Deshalb hier mal die info wie sowas richtig geht, hier mal allgemein für die Root geschrieben und jedes beliebige Unterverzeichnis.

RewriteEngine on

#

# Redirect von der index.html aus beliebigen Verzeichnis in die "/" des selben Verzeichnisses

#

RewriteCond %{THE_REQUEST} ^[A-Z]{3,9}\ /([^/]+/)*index\.html?\ HTTP/

RewriteRule ^(([^/]+/)*)index\.html?$ http://www.example.com/$1 [R=301,L]

#

Redirect permanent /d/index.html http://www.meinedomain.com/d/

Das Ganze hat dann einen Loop erzeugt der zu Folge hatte, dass die Seite nicht mehr erreichbar war.

Deshalb hier mal die info wie sowas richtig geht, hier mal allgemein für die Root geschrieben und jedes beliebige Unterverzeichnis.

RewriteEngine on

#

# Redirect von der index.html aus beliebigen Verzeichnis in die "/" des selben Verzeichnisses

#

RewriteCond %{THE_REQUEST} ^[A-Z]{3,9}\ /([^/]+/)*index\.html?\ HTTP/

RewriteRule ^(([^/]+/)*)index\.html?$ http://www.example.com/$1 [R=301,L]

#

Donnerstag, 24. Februar 2011

ROI Betrachtungen beim Keyword Research

Die Wahl der richtigen Keywords trägt maßgeblich zum Erfolg eines SEO Projektes bei. Hier gibt es aufwendige Vorgehensweisen die rentabelsten Keywords zu bestimmen. Die sinnvolle Mischung zwischen den Wünschen des Kunden und der rentabelsten Keywords aus SEO Sicht zu finden ist dabei nicht immer ganz einfach. Klar sucht sich der Kunde immer intuitiv die hart umkämpftesten Main Keywords aus, während der gute SEO Dienstleister auf trafficstarke Nischenkeywords mit geringer Mitbewerberdichte setzt. Hier ist es die manchmal schwierige Aufgabe den Kunden davon zu überzeugen, dass für einen optimalen Erfolg nicht der intuitive Wunsch nach Top Rankings bei den Main Keywords die beste Strategie ist, sondern viel mehr möglichst viel qualitativ hochwertiger Traffic mit überschaubaren Aufwand.

Doch wie bewertet man als SEO den ROI einer Kampagne? Sich an den Leads, Conversions oder Operations zu orientieren ist sicher nicht der beste Weg, da der SEO Dienstleister ja nicht absehen kann wie gut das Angebot der Webseite ist, er ist ja nur für die qualitativ hochwertige Trafficerzeugung zuständig.

Ein guter Ansatz eine SEO Kampagne zu bewerten, kann aber der Vergleich zu den Gesamtkosten einer SEA Kampagne sein. Die voraussichtlichen CPC für die Keywords und damit die äquivalenten Schaltungskosten für den Traffic der SEO Kampagne lassen sich eindeutig bestimmen.

Wenn man den ROI nun gemäß der Definition Gewinn im Verhältnis zum eingesetzten Kapital betrachtet, kann also der Gewinn in der einfachsten Form gleich dem zum SEO Traffic äquivalenten Schaltungskosten des SEA Taffic sein.

Bei dieser Betrachtung sollte man jedoch auch die Kampagenmanagementkosten einer SEA Kampagne entsprechend berücksichtigen und der Traffic auf die Keywords, der mehr oder weniger im Fahrwasser der SEO Kampagne aufgrund der Offpageoptimierung entsteht. Ausserdem lassen sich hierbei, aufgrund der zeitverzögerten Performance einer SEO Kampagne im Gegensatz zur einer SEA Kampagne, keine kurzfristigen Aussagen machen. Erst wenn die SEO Kampagne die weitgehend gewünschte Performance erreicht hat, kann man am monatlich erzeugtem Traffic hochrechnen wie rentabel die Kampagne im Vergleich zu einer SEA Kampagne ist.

Doch wie bewertet man als SEO den ROI einer Kampagne? Sich an den Leads, Conversions oder Operations zu orientieren ist sicher nicht der beste Weg, da der SEO Dienstleister ja nicht absehen kann wie gut das Angebot der Webseite ist, er ist ja nur für die qualitativ hochwertige Trafficerzeugung zuständig.

Ein guter Ansatz eine SEO Kampagne zu bewerten, kann aber der Vergleich zu den Gesamtkosten einer SEA Kampagne sein. Die voraussichtlichen CPC für die Keywords und damit die äquivalenten Schaltungskosten für den Traffic der SEO Kampagne lassen sich eindeutig bestimmen.

Wenn man den ROI nun gemäß der Definition Gewinn im Verhältnis zum eingesetzten Kapital betrachtet, kann also der Gewinn in der einfachsten Form gleich dem zum SEO Traffic äquivalenten Schaltungskosten des SEA Taffic sein.

Bei dieser Betrachtung sollte man jedoch auch die Kampagenmanagementkosten einer SEA Kampagne entsprechend berücksichtigen und der Traffic auf die Keywords, der mehr oder weniger im Fahrwasser der SEO Kampagne aufgrund der Offpageoptimierung entsteht. Ausserdem lassen sich hierbei, aufgrund der zeitverzögerten Performance einer SEO Kampagne im Gegensatz zur einer SEA Kampagne, keine kurzfristigen Aussagen machen. Erst wenn die SEO Kampagne die weitgehend gewünschte Performance erreicht hat, kann man am monatlich erzeugtem Traffic hochrechnen wie rentabel die Kampagne im Vergleich zu einer SEA Kampagne ist.

Montag, 21. Februar 2011

innovatives Linkbuilding am Beispiel elementsurf

Die eigene Webseite bei den Google Suchergebnissen nach vorne zu bringen ist gerade in einem Marktumfeld mit schwieriger Konkurrenz meist nur mit großem Aufwand möglich. Wenn die Onpageoptimierung perfektioniert ist, sind hochwertige Backlinks das was zählt. Hier hilft ein üppiges Budget um das voranzutreiben. Aber was tun wenn man kein üppiges Budget hat ? Dann helfen wohl nur innovative, kreative Ideen.

Zu der Gruppe an Menschen denen es an sowas nicht mangelt gehören die Surfer. Nein, damit meinen wir hier nicht die blassen Nerds, die viel Zeit im Internet verbringen. Damit meinen wir die Wellenreiter, Lebenskünstler, die mit kleinem Reisebudget möglichst viel an schönen Stränden mit guten Wellen sein wollen.

Was das mit Linkbuilding zu tun hat ?

Uns ist eine innovative Idee der Firma elementsurf aufgefallen. Hier wird, extrem stylisch aufgemacht, ein Surftrip unter allen Leuten verlost, die einen Backlink auf die Seite setzen. Das wird den SEO Spezialisten jetzt nicht vom Hocker hauen, weil welcher Surfer hat schon eine eigene, starke Webseite? Aber auch daran haben die Leute von Elementsurf gedacht. Das Tutorial wie man einen Blog in 3 Minuten erstellt ist gleich dabei. Damit das ganze themenspezifisch verlinkt wird, sind die Teilnahmebedingungen so:

"Berichte einfach innerhalb der nächsten zwei Wochen auf deiner Website oder deinem Blog über uns oder unsere Aktion. Also schreibt was, macht ne Fotostory, dreht ein Video oder was auch immer euch einfällt, der Kreativität sind keine Grenzen gesetzt! Wenn dein Bericht online ist, schreibst Du unter diesem Artikel hier einen kurzen Kommentar mit dem Hinweis wo wir deinen Artikel finden können. Und zack sind die Teilnahmebdingungen erfüllt."

Wir finden das eine super Sache und geben dicke Props an die Leute von Elementsurf für diese kreative Idee !

Ach so ja. Und den Backlink auf die Aktion gibts hier natürlich auch noch. Und weil wir unser Handwerk ja verstehen sogar mit perfektem Anchor Text:

Element Surfcamp Spanien

Welche anderen Webseiten liegen auf einer IP / Server ?

Wenn man als Webmaster nur einen Webspace angemietet hat, kann es manchmal von Bedeutung sein, mit welchen anderen Seiten man sich eine IP / Server teilt. Sind das Seiten mit Spam, kritischen Inhalten oder sonstigem was Google nicht mag, kann das unter Umständen schlecht für den Thrust und damit das Ranking der eigenen Seite sein.

Hier mal ein Tool, mit dem man herausfinden kann, mit welchen anderen Domains man ich einen Server / eine IP teilt:

http://com.safersite.de

Hier mal ein Tool, mit dem man herausfinden kann, mit welchen anderen Domains man ich einen Server / eine IP teilt:

http://com.safersite.de

Sonntag, 20. Februar 2011

SEO Strategien bei Seiten mit strukturellen Schwächen

Nicht immer kann man als SEO Dienstleister die Struktur der Webseite dahingehend beeinflussen, dass sie im Sinne einer Offpageoptimierung perfekt ist. Wie sowas aussehen sollte, haben wir hier ja schon teilweise im Post vertikale und horizontale Navigierbarkeit behandelt.

Seiten mit strukturellen Schwächen sind häufig, hier die Klassiker:

- Seiten mit Einstiegs oder Sprachenauswahlseite ohne Content

- Seiten mit Bildnavigation ohne Pulldowns zu tieferen Deeplinks

- Flashheiten oder Seiten mit Flashnavigation

- zielkeywordrelevanter Content ungünstig auf die Unterseiten verteilt

- Seiten mit Framesets

Nun kann man sich als SEO Dienstleister nicht immer die Kunden und deren Webseiten aussuchen. Grundsätzlich sollte man bei Problemen wie oben natürlich den Relaunch mit einem modernen CMS empfehlen und damit alle Strukturschwächen beseitigen. Aber das geht natürlich aus Aufwandsgründen oft nicht. Lediglich bei letztem Punkt (Framesets) sollte man wirklich über einen Relaunch nachdenken.

Ansonsten kann man in die Trickkiste greifen um die strukturellen Schwächen zu beseitigen. Hier ein paar Anregungen.

Footermenü

Ist in Hinblick auf die Usability der Seite nicht wirklich notwendig, vor allem wenn man scrollen muss um es überhaupt zu sehen. Ausserdem macht es eine Webseite nicht unbedingt schöner. Aber damit kann man eine direktere zielkeywordbezogene Verlinkung auf die Unterseiten erreichen.

Tagclouds

Gleichen Effekt kann man auch mit einer Tagcloud erreichen. Die lässt bei nicht CMS Seiten sogar statisch generieren. Aber schön ist sowas natürlich noch weniger.

Themenspezifische Zusatzseiten

Erstellen von einer Art Glossarseiten, die sich nur mit dem Thema eines Zielkeywords beschäftigt. Diese sollten dann mit einem Textlink direkt von der Startseite verlinkt sein. Wenn hier alle Onpage Faktoren sauber optimiert sein, kann man damit durchaus auch viel Traffic direkt auf die optimierten deeplinks einsammeln.

Seiten mit strukturellen Schwächen sind häufig, hier die Klassiker:

- Seiten mit Einstiegs oder Sprachenauswahlseite ohne Content

- Seiten mit Bildnavigation ohne Pulldowns zu tieferen Deeplinks

- Flashheiten oder Seiten mit Flashnavigation

- zielkeywordrelevanter Content ungünstig auf die Unterseiten verteilt

- Seiten mit Framesets

Nun kann man sich als SEO Dienstleister nicht immer die Kunden und deren Webseiten aussuchen. Grundsätzlich sollte man bei Problemen wie oben natürlich den Relaunch mit einem modernen CMS empfehlen und damit alle Strukturschwächen beseitigen. Aber das geht natürlich aus Aufwandsgründen oft nicht. Lediglich bei letztem Punkt (Framesets) sollte man wirklich über einen Relaunch nachdenken.

Ansonsten kann man in die Trickkiste greifen um die strukturellen Schwächen zu beseitigen. Hier ein paar Anregungen.

Footermenü

Ist in Hinblick auf die Usability der Seite nicht wirklich notwendig, vor allem wenn man scrollen muss um es überhaupt zu sehen. Ausserdem macht es eine Webseite nicht unbedingt schöner. Aber damit kann man eine direktere zielkeywordbezogene Verlinkung auf die Unterseiten erreichen.

Tagclouds

Gleichen Effekt kann man auch mit einer Tagcloud erreichen. Die lässt bei nicht CMS Seiten sogar statisch generieren. Aber schön ist sowas natürlich noch weniger.

Themenspezifische Zusatzseiten

Erstellen von einer Art Glossarseiten, die sich nur mit dem Thema eines Zielkeywords beschäftigt. Diese sollten dann mit einem Textlink direkt von der Startseite verlinkt sein. Wenn hier alle Onpage Faktoren sauber optimiert sein, kann man damit durchaus auch viel Traffic direkt auf die optimierten deeplinks einsammeln.

Dienstag, 15. Februar 2011

Firefox Beta: keine Cookies mehr von Werbenetzwerken

Mal eine erfreuliche Meldung: Firefox schiebt dem Tracking des Benutzerverhaltens von Werbenetzwerken (endlich) einen Riegel vor. Retargeting und nervige personalisierte Werbung kann man damit hoffentlich nachhaltig ausschliessen, während der Browser wichtige Cookies noch zulässt. Der User kann also nun User selbst entscheiden, ob Werbenetzwerke ihre Aktivitäten zur Auslieferung von personalisierten und lokalisierten Werbeeinblendungen in einem Cookie speichern dürfen oder nicht. Bisher war das Cookie Management im Firefox eher schwach. Wir freuen uns darauf weniger getrackt zu werden. Das Ganze gibt es ab der Version Firefox 4.0 b11.

Sonntag, 13. Februar 2011

Erweitertes SEO - wo solls hingehen?

Klassisches SEO baut auf die Säulen On- und Offpageoptimierung. Das sollte handwerklich solide gemacht werden und die Möglichkeiten, hier mit Tricks die gegen die Richtlinien von Google verstossen das Ranking zu beeinflussen sind begrenzt und nicht unbedingt empfehlenswert.

Anders schaut es im Bereich Social Media und bei den Bewertungspotalen aus.

Google wertet z.B. die Twitteraktivitäten von Unternehmen aus. Tweed Ranks und auch die "Qualität" der Follower fliessen in die Bewertung der Unternehmenswebseite ein. Nun liegt es dann natürlich nahe, dass manche anfangen gefakte Follower mit hoher Qualität zu erstellen um damit das Ranking der Webseite zu beeinflussen.

Genauso schaut es mit den Bewertungsportalen aus. Gerade bei Angeboten mit regionalem Bezug kann man sich unter Umständen mit geschicktem Faken von Bewertungen viel einfacher nach oben pushen, als mit klassischer SEO.

Es bleibt abzuwarten wohin die Reise gehen soll und inwieweit sich mal wieder mal die Arbeit von SEOs verändert.

Anders schaut es im Bereich Social Media und bei den Bewertungspotalen aus.

Google wertet z.B. die Twitteraktivitäten von Unternehmen aus. Tweed Ranks und auch die "Qualität" der Follower fliessen in die Bewertung der Unternehmenswebseite ein. Nun liegt es dann natürlich nahe, dass manche anfangen gefakte Follower mit hoher Qualität zu erstellen um damit das Ranking der Webseite zu beeinflussen.

Genauso schaut es mit den Bewertungsportalen aus. Gerade bei Angeboten mit regionalem Bezug kann man sich unter Umständen mit geschicktem Faken von Bewertungen viel einfacher nach oben pushen, als mit klassischer SEO.

Es bleibt abzuwarten wohin die Reise gehen soll und inwieweit sich mal wieder mal die Arbeit von SEOs verändert.

Mittwoch, 9. Februar 2011

SEO und die Webkataloge

Eine der beliebtesten Spielwiesen von SEO Einsteigern sind die Webkataloge. Hiervon gibt es tausende. Man muss nicht viel nachdenken und kann stumpf seine Webseite in einen nach dem anderen eintragen. Andere nutzen Eintragungsservices in Webkataloge und sind der Meinung sie tun ihrer Webseite damit was Gutes.

Wenn man genau hinschaut, sollte man sich wundern, dass grosse Webkataloge mit mehreren tausend Einträgen und vielen Backlinks einen PR vom 0 haben. Das "blüht" allen Webkatalogen die zu den Einträgen keinen unique Content haben, sondern duplicate Content mit anderen Webkatalogen.

Grundsätzlich gilt: Masseneintragungen, die manchmal als schneller SEO-Workaround angeboten oder durchgeführt werden, sind weitestgehend nutzlos.

Es gibt natürlich eine Handvoll Verzeichnisse die von hoher Qualität sind und auch für Google relevant sind. Dagegen sind aber der überwiegende Teil von Webverzeichnissen von geringer Qualität und bringen vernachlässigbar wenig für die eigene Webseite.

Wenn man genau hinschaut, sollte man sich wundern, dass grosse Webkataloge mit mehreren tausend Einträgen und vielen Backlinks einen PR vom 0 haben. Das "blüht" allen Webkatalogen die zu den Einträgen keinen unique Content haben, sondern duplicate Content mit anderen Webkatalogen.

Grundsätzlich gilt: Masseneintragungen, die manchmal als schneller SEO-Workaround angeboten oder durchgeführt werden, sind weitestgehend nutzlos.

Es gibt natürlich eine Handvoll Verzeichnisse die von hoher Qualität sind und auch für Google relevant sind. Dagegen sind aber der überwiegende Teil von Webverzeichnissen von geringer Qualität und bringen vernachlässigbar wenig für die eigene Webseite.

Dienstag, 8. Februar 2011

Google warnt vor dem Einsatz von Mietlinks

Mit einem Post am 7. Februar hat sich Google in die Diskussionen in deutschen SEO Blogs über gekaufte und verkaufte Links eingeschaltet.

Die Aussagen sind eindeutig:

"Kauft keine Links für PageRank, und verkauft sie auch nicht."

"Die Tatsache, dass Links gekauft und verkauft werden, ist nichts Neues, und wir können solche Links inzwischen gut erkennen."

"Wenn ihr Links kauft, ist es recht wahrscheinlich, dass wir sie nicht mehr berücksichtigen, so dass ihr möglicherweise viel Zeit und Geld dafür verwenden würdet und eure Rankings trotzdem sinken.".

Was passiert wenn Google einen Webmaster dem Einsatz von gekauften und verkauften Links überführt wird nur angedeutet:

"Wir möchten nicht zu sehr ins Detail gehen, aber wenn zum Beispiel klar ist, dass Links auf einigen Seiten keine wirklichen “Empfehlungen” für andere Websites sind, könnten wir diese Seiten davon abhalten, PageRank weiterzugeben."

Ausdrücklich ruft Google Webmaster auf, Google zu helfen und Seiten mit Mietlinks zu melden. Das verschärft die Situation für Webseitenbetreiber die Mietlinks einsetzen, da die Konkurrenz sie natürlich jederzeit bei Google "anschwärzen" kann.

Auf welcher Webseite man Mietlinks melden kann hat Google nochmal allen registrierten Webmaster geschickt. Hier kann man Mietlinks melden (nur für registrierte Webmaster).

Das ganze Thema zeigt auch, wie wichtig es ist, dass Firmen die mit Suchmaschinenoptimieren (SEO) zusammenarbeiten, sorgfältig den richtigen Partner auswählen sollten und dafür sorgen sollten, dass sie sich an die Richtlinien für Webmaster hält.

Mehr zum Thema SEO Dienstleister und Vorgehensweisen beim SEO findet ihr hier:

Vorgehen inite SEO Unit

Wechsel des SEO Dienstleisters

Die Aussagen sind eindeutig:

"Kauft keine Links für PageRank, und verkauft sie auch nicht."

"Die Tatsache, dass Links gekauft und verkauft werden, ist nichts Neues, und wir können solche Links inzwischen gut erkennen."

"Wenn ihr Links kauft, ist es recht wahrscheinlich, dass wir sie nicht mehr berücksichtigen, so dass ihr möglicherweise viel Zeit und Geld dafür verwenden würdet und eure Rankings trotzdem sinken.".

Was passiert wenn Google einen Webmaster dem Einsatz von gekauften und verkauften Links überführt wird nur angedeutet:

"Wir möchten nicht zu sehr ins Detail gehen, aber wenn zum Beispiel klar ist, dass Links auf einigen Seiten keine wirklichen “Empfehlungen” für andere Websites sind, könnten wir diese Seiten davon abhalten, PageRank weiterzugeben."

Ausdrücklich ruft Google Webmaster auf, Google zu helfen und Seiten mit Mietlinks zu melden. Das verschärft die Situation für Webseitenbetreiber die Mietlinks einsetzen, da die Konkurrenz sie natürlich jederzeit bei Google "anschwärzen" kann.

Auf welcher Webseite man Mietlinks melden kann hat Google nochmal allen registrierten Webmaster geschickt. Hier kann man Mietlinks melden (nur für registrierte Webmaster).

Das ganze Thema zeigt auch, wie wichtig es ist, dass Firmen die mit Suchmaschinenoptimieren (SEO) zusammenarbeiten, sorgfältig den richtigen Partner auswählen sollten und dafür sorgen sollten, dass sie sich an die Richtlinien für Webmaster hält.

Mehr zum Thema SEO Dienstleister und Vorgehensweisen beim SEO findet ihr hier:

Vorgehen inite SEO Unit

Wechsel des SEO Dienstleisters

Donnerstag, 3. Februar 2011

Description Tag - Ranking Faktor oder nicht?

Zwei Sachen sind sicher: Der Description Tag wird sehr oft von Google für das Sniplet hergenommen und man sollte nicht mehr als 150-160 Zeichen dafür verwenden.

Die einen packen den Description Tag mit Keywords voll, die anderen nehmen einen Marketingtext, um den CTR zu erhöhen.

Wer hat Recht ? Ich denke beide.

Halten wir uns mal an die Aussagen von Rand Fishkin und den Expert Opinions der Inbound Marketing University. Danach hat der "Keyword Use in Meta Description Tag" einen "moderate Impact" auf das Ranking.

Andererseits sind (selbe Quelle) aus der Expert Opinion bei der relativen Wichtigkeit von Algo Komponenten bei Google die Traffic und CTR Data mit 7 % angegeben, dagegen steht der Onpage Keyword Use mit 15 %.

Also ist das Beste wohl ein guter Marketingtext mit eingebetteten Main Keywords.

Die einen packen den Description Tag mit Keywords voll, die anderen nehmen einen Marketingtext, um den CTR zu erhöhen.

Wer hat Recht ? Ich denke beide.

Halten wir uns mal an die Aussagen von Rand Fishkin und den Expert Opinions der Inbound Marketing University. Danach hat der "Keyword Use in Meta Description Tag" einen "moderate Impact" auf das Ranking.

Andererseits sind (selbe Quelle) aus der Expert Opinion bei der relativen Wichtigkeit von Algo Komponenten bei Google die Traffic und CTR Data mit 7 % angegeben, dagegen steht der Onpage Keyword Use mit 15 %.

Also ist das Beste wohl ein guter Marketingtext mit eingebetteten Main Keywords.

Dienstag, 25. Januar 2011

Page Rank update bei Google